مدلهای زبانی بزرگ یا همان LLM ها میتوانند مجموعه وسیعی از وظایف پردازش زبان طبیعی مانند تولید متن، ترجمه، تجزیه و تحلیل احساسات و گفتوگوهای چتباتها و موارد دیگر را فراهم کنند. مدلهای زبانی مانند GPT، بر روی مجموعه دادههای عظیم و پلتفرمهای مبتنی بر هوش مصنوعی آموزش دیدهاند تا بتوانند متنی منسجم و مرتبط تولید کنند. 60 درصد از پاسخدهندگان در کنفرانس آینده هوش مصنوعی دادهمحور که در سال 2023 برگزار شد اعلام کردند که قصد دارند ظرف شش ماه آینده از LLMها استفاده کنند.

برای ساخت یک مدل زبانی هوش مصنوعی به ترکیبی از زیرساختهای سختافزاری، نرمافزارهای مناسب و همچنین نیروی انسانی کارآمد و متخصص نیاز داریم. در این میان، زیرساختهای پردازشی قدرتمند از اهمیت فوقالعادهای برخوردارند زیرا که مدلهای زبانی مبتنی بر یادگیری ماشین و یادگیری عمیق به دلیل داشتن میلیونها یا میلیاردها پارامتر، نیازمند محاسبات بسیار سنگین و پردازش موازی هستند. اگر میخواهید با زیرساختهای پردازشی مورد نیاز برای توسعه مدلهای زبانی آشنا شوید، در این یادداشت همراه ما باشید تا نگاهی اجمالی به مهمترین زیرساختهای پردازشی که نقش حیاتی در توسعه مدلهای زبانی دارند، بیندازیم.

زیرساخت پردازشی چیست؟

زیرساخت پردازشی در هوش مصنوعی به سختافزارها، نرمافزارها و شبکههایی گفته میشود که برای پردازش و تحلیل دادههای بزرگ در سیستمهای هوش مصنوعی که شامل یادگیری ماشین و یادگیری عمیق است به کار گرفته میشود. مواردی مانند سرورهای پرقدرت برای پردازش موازی و توزیع شده، شبکههایی با سرعت و پهنای باند بالا برای انتقال سریع دادهها، سیستم ذخیرهسازی با ظرفیت بالا جهت ذخیرهسازی دادههای بزرگ، واحد پردازش مرکزی و کارتهای گرافیک قدرتمند از جمله زیرساختهای پردازشی محسوب میشوند که امکان پردازش حجم وسیع و عظیمی از دادهها را در کسری از ثانیه فراهم میکنند. این پردازندهها با فراهم کردن قدرت محاسباتی لازم، ذخیرهسازی پایدار و مقیاسپذیری بالا، زمینه را برای تحلیل دادههای بزرگ و اجرای موفق الگوریتمهای پیچیده یادگیری ماشین و یادگیری عمیق فراهم میکنند. استفاده از چنین زیرساختهایی پایه و اساس ساخت و توسعه مدلهای زبانی را تشکیل میدهد.

اهمیت زیرساخت پردازشی در توسعه مدلهای زبانی

همانطور که گفتیم زیرساختهای پردازشی قدرتمند برای توسعه مدلهای زبانی بزرگ بسیار حیاتی و تعیینکنندهاند. مدلهای زبانی بزرگ برای انجام وظایفی مانند تولید متن، ترجمه ماشینی و… نیازمند آموزش حجم عظیمی از دادههای متنی و انجام محاسبات پیچیده روی این دادهها هستند و پردازش چنین دادههایی تنها با بهرهگیری از زیرساختهای نرمافزاری و سختافزاری بسیار قدرتمند امکانپذیر است. به عنوان مثال شبکههای پرسرعت، پردازندههای گرافیکی ویژه، ابررایانهها از جمله این زیرساختها محسوب میشوند و دسترسی به آنها یک مزیت رقابتی مهم برای موسسات و شرکتهای فعال در حوزه هوش مصنوعی به شمار میرود.

پردازندههای مورد نیاز برای توسعه مدلهای زبانی

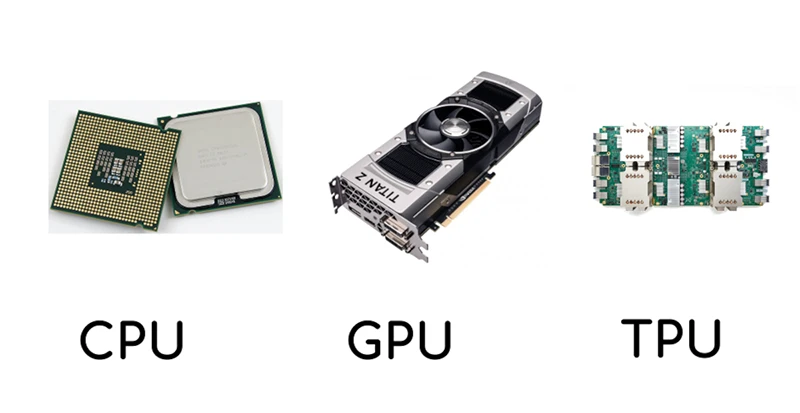

برای توسعه مدلهای زبانی از سه زیرساخت کلیدی واحد پردازش مرکزی، واحد پردازش گرافیکی و واحد پردازش ترانسور استفاده میشود. به غیر ازCPU ها که نقش محوری در اجرای بخشی از محاسبات و وظایف کنترل و مدیریت سیستم دارند، امروزه از پردازندههای گرافیکی ویژه یا همان GPU ها به طور گستردهای برای آموزش مدلهای عمیق یادگیری ماشین مانند مدلهای زبان طبیعی استفاده میشود. GPUها با بهرهگیری از هزاران هسته پردازشی، قابلیت پردازش موازی دادهها را به طور قابل توجهی افزایش میدهند. این ویژگی باعث شده تا زمان آموزش مدلهای زبانی پیچیده از چندین ماه به چند روز یا حتی چند ساعت کاهش یابد. علاوه بر GPU ها از پردازندههای تخصصیتر مانند TPU که توسط شرکت گوگل طراحی شده نیز میتوان بهره برد. این پردازندههای تخصصی برای پردازش بهینه عملیات مرتبط با یادگیری عمیق و شبکههای عصبی طراحی شدهاند و بازدهی بسیار بالاتری نسبت GPUهای استاندارد دارند. در ادامه این زیرساخت اصلی را به طور مفصلتر معرفی خواهیم کرد.

واحد پردازش مرکزی CPU

برای توسعه مدلهای زبانی، واحد پردازش گرافیکی اصلیترین بار محاسبات شبکه عصبی را بر عهده دارد، واحد پردازش مرکزی یا همان Central processing unit که به اختصار سی پی یو نامیده میشود، همچنان نقشی حیاتی در پیشپردازش دادهها، تنظیم مدل و هماهنگی عملیات بر عهده دارند. یک پردازنده چند هستهای قدرتمند میتواند به طور قابل توجهی سرعت بارگذاری دادهها، پیشپردازش و وظایف پیکربندی مدل را افزایش دهد. با این حال، در حوزه هوش مصنوعی، برای مرحله واقعی آموزش ماشینها، تواناییهای پردازش موازی جی پی یوها در مرکز توجه قرار دارد.

کاربرد زیر ساخت پردازشی CPU در هوش مصنوعی

CPU ها برای فرایندهای پردازش دادهمحور یادگیری ماشین به عنوان کارآمدترین گزینه شناخته نمیشوند، اما زمانی که استفاده از GPU ها مناسب نیست، یک گزینه مقرون به صرفه هستند. علاوه بر این، از این زیرساخت پردازشی میتوان در دادههای سری زمانی که نیاز به محاسبات موازی ندارد و سیستمهای توصیهگر مانند توصیه فیلم یا محصول که برای آموزش به حافظه زیادی برای ذخیره اطلاعات نیاز دارند، استفاده کرد. به طور کلی میتوان گفت که هرچند GPU ها برای یادگیری ماشین مفید هستند، اما همیشه بهترین گزینه برای همه موارد نیستند و بسته به الگوریتم و کاربرد مورد نظر، CPU ها همچنان گزینه مناسب و مقرونبهصرفهای به حساب میآیند.

واحد پردازش گرافیکی GPU

واحد پردازش گرافیکی یا همان Graphics Processing Unit که به اختصار GPU نامیده میشود، به دلیل توانایی عظیمشان در شتاب دادن به محاسبات موازی، سنگ بنای آموزش مدلهای زبانی و از مهمترین زیرساختهای پردازشی مورد نیاز برای توسعه مدلهای زبانی محسوب میشوند. فریمورکهای یادگیری عمیق مانند TensorFlow و PyTorch برای انجام ضرب ماتریسها و دیگر عملیات مورد نیاز برای آموزش شبکههای عصبی از GPU ها استفاده میکنند.

برای اینکه مناسبترین واحد پردازش گرافیکی را انتخاب کنید باید به عوامل مختلفی مانند ظرفیت حافظه (VRAM)، پهنای باند حافظه و قدرت پردازشی کنید. GPU های قدرتمند مانند مانند سری Tesla انویدیا یا سری GeForce RTX معمولا برای آموزش LLM ها ترجیح داده میشوند. هرچه GPU قدرتمندتر باشد، فرایند آموزش سریعتر انجام خواهد شد.

GPU ها چگونه کار میکنند؟

در حالی که CPU ها معمولا تعداد هستههای کمتری دارند که با سرعت بالا کار میکنند، GPU ها دارای هستههای پردازشی بسیار زیادی هستند که با سرعت پایینتر کار میکنند. وقتی که به GPU یک تسک داده میشود، آن را به هزاران زیرتسک کوچکتر تقسیم و به طور همزمان پردازش میکند.

در رندرینگ گرافیکی، GPU ها محاسبات ریاضی و هندسی پیچیدهای را برای ایجاد افکت و تصاویر بصری واقعگرایانه انجام میدهد. دستورالعملها باید به طور همزمان اجرا شوند تا تصاویر صدها بار در ثانیه ترسیم و بازترسیم شوند تا تجربه بصری مشخص و واضحی ایجاد شود. GPU ها همچنین پردازش پیکسل را انجام میدهند، یک فرایند پیچیده که نیاز به توان پردازشی عظیم برای رندر لایههای متعدد و ایجاد بافتهای پیچیده ضروری برای گرافیک واقعگرایانه دارد. پس این سطح بالای توان پردازشی است که GPU ها را برای یادگیری ماشین، هوش مصنوعی و سایر تسکهایی که نیاز به محاسبات پیچیده دارند، مناسب میسازد.

واحد پردازش تانسور TPU

گفتیم که در دنیای پیچیده و درهمتنیده هوش مصنوعی، سختافزارها نقشی حیاتی ایفا میکنند. همانطور که یک صنعتگر برای ساخت یک محصول باکیفیت و خلاقانه به تجهیزات مناسب و با دقت بالا نیاز دارد، مدلهای هوش مصنوعی هم به سختافزارها و زیرساختهای پردازشی تخصصی نیاز دارند تا به طور کارا عمل کنند. در میان زیرساختهای پردازشی موجود، واحد پردازش تانسور مانند یک نورافکن در حوزه سختافزار هوش مصنوعی محسوب میشود.

واحد پردازش تانسور یا همان Tensor Processing Unit که به اختصار TPU نامیده میشود، یک سختافزار تخصصی است که توسط گوگل برای شتاببخشی به وظایف یادگیری ماشین طراحی شده است. این واحد به خوبی در عملیات رایج شبکههای عصبی مانند ضرب ماتریسها عمل میکند و نسبت به CPU ها و GPU های سنتی بهرهوری و کارایی بهتری دارد. TPU ها به صورت عمیقی با چارچوب TensorFlow گوگل یکپارچه شدهاند به گونهای که آموزش و استنتاج مدلهای هوش مصنوعی را به سرعت انجام میدهند.

در مقایسه با GPUها، TPU ها برای کاربردهای هوش مصنوعی تولیدی و مدلهای زبانی بزرگ انتخاب بهتری محسوب میشود. دلیل این امر این است که TPU به طور خاص برای عملیات جبر خطی که در الگوریتمهای یادگیری ماشین به کار میرود، طراحی و بهینه شده است. از جمله مزایای TPU نسبت به GPU میتوان به بالاتر بودن نسبت عملیات شناور به هر واحد مصرف انرژی، کارایی بالاتر در پردازش دادههای حجیم، قابلیت مقیاسپذیری و خوشهبندی بهتر، و همچنین بهینهسازی آن برای عملیات ضرب ماتریسی اشاره کرد. بنابراین به دلیل ویژگیهای ذکر شده، TPU گزینهی مناسبتری برای پیادهسازی مدلهای پیچیده و بزرگ مانند هوش مصنوعی تولیدی و مدلهای زبان طبیعی نسبت به GPUها است.

تفاوت میان CPU و GPU و TPU

CPU ها واحدهای پردازش مرکزی هستند که کارهای مختلف رایانه را مدیریت میکنند. آنها چند هسته دارند و برای پردازشهای سریالی مناسبند. GPU ها برای بهبود عملکرد گرافیکی و محاسبات موازی طراحی شدهاند. آنها هزاران هسته دارند و میتوانند هزاران عملیات را به طور همزمان انجام دهد. اما TPUها پردازندههای سفارشی هستند که به طور خاص برای شتابدهی پروژههای مبتنی بر تنسورفلو ساخته شدهاند. آنها سختافزار ویژهای برای پردازش ماتریس دارند و برای محساب موازی مناسب هستند. بنابراین تفاوت اصلی میان این سه زیرساخت پردازشی برای مدل های زبانی، در نوع کاربرد، تعداد هسته و توان محاسباتی آنهاست.

در مجموع میتوان گفت که سه زیرساخت پردازشی کلیدی شامل CPU، GPU و TPU هر کدام نقش مکملی در توسعه و اجرای مدلهای زبانی دارند. در حالی که GPU ها بار اصلی محاسبات شبکه عصبی را برای آموزش مدل بر عهده دارند، CPU ها معمولا در مراحل پیشپردازش داده و بهینهسازی مدل نقش ایفا میکنند. از سوی دیگر TPU ها به دلیل بهینه شدن برای عملیات جبر خطی، انتخاب مناسبتری برای اجرای مدلهای زبانی بزرگ هستند. در نهایت با ترکیب صحیح این سه زیرساخت میتوان به بهترین نحوه امکان توسعه و استقرار مدلهای زبانی پیشرفته را فراهم نمود.

چالشها و محدودیتهای زیرساختهای پردازشی هوش مصنوعی

با وجود پیشرفتهایی که در حوزه زیرساختهای پردازشی هوش مصنوعی وجود داشته، هنوز چالشها و محدویتهایی برای فراهم کردن زیرساخت پردازشی مدلهای زبانی وجود دارد که نیازمند توجه و سرمایهگذاری بیشتری است. به عنوان مثال هزینههای سرسامآور تامین و نگهداری سختافزارها و پردازندههای مختلف، مانعی بزرگ برای بسیاری از شرکتها و موسسات دانشگاهی به شمار میرود.

همانطور که هوش مصنوعی از مرحله آزمایشی فراتر میرود و در حال گسترش است نیازمند منابع محاسباتی و هزینههای زیرساختی قابل توجهی خواهد بود و با پیچیده شدن فناوری و نیاز روز افزون آن به منابع مختلف، هزینهها به شدت افزایش خواهد یافت. در چنین شرایطی دسترسی به محیطهای اجرایی کمهزینه برای فرایندهای پردازشی پرتوان، هم یک الزام و هم یک مزیت رقابتی به شمار میرود. ممکن است بزرگترین سوال برای سازمانهایی که توسعه یک مدل زبانی را دارند این باشد که چه زیرساخت مناسبی اجازه استفاده، توسعه و پیادهسازی مداوم هوش مصنوعی را میدهد.

با پیچیدهتر شدن مدلهای هوش مصنوعی، هزینه اجرای آنها بیشتر میشود. بنابراین بهینهسازی عملکرد زیرساخت برای کنترل هزینهها حیاتی است. شناسایی ارائهدهندگانی که میتوانند زیرساختهای مقرونبهصرفه ارائه کنند، فرصتی برای افزایش عملکرد ایجاد میکنند تا شرکتها بدون افزایش بودجه بتوانند به سرمایهگذاری در هوش مصنوعی ادامه دهند.